本記事は、情報理論の基礎である「情報源符号化」のまとめ記事シリーズの第3章です。

「情報源符号化」のまとめ記事では、「エントロピー」から始まり「条件付きエントロピー」「相互情報量」「通信路容量」「平均誤り率」「情報速度」について解説していきます。

統一した例題を使用しますので、ご安心して学んでいただけます。

第3章では「相互情報量」に焦点を当て、

その定義や意味、具体的な計算方法について解説します。

前回の「条件付きエントロピー」について解説した記事は↓になります。

相互情報量とは?

情報源X,Yがあった場合、一方の情報源から他方の情報源にどのくらい情報が得られるかを定量的に測るものが相互情報量となります。

相互情報量はI(X;Y)と表されます。

相互情報量は、

2つの事象X,Yが独立か独立でないかで分けることができます。

X,Yの事象が互いに独立の場合は相互情報量I(X;Y)=0となります。

単位は[ビット/記号]となります。

〇XとYが互いに独立していない場合

(Xの生起とYの生起に関係性がある)

例えば、

「Xの事象は2回投げた時コインの表が出る回数」

「Yの事象は2回目にコインが表の確率」

2回コインを投げて表が2回出たら、2回目にコインが表だった確率が予測できます。

この場合は、Xの事象がYに影響しています。

この関係をXとYが互いに独立でないと言います。

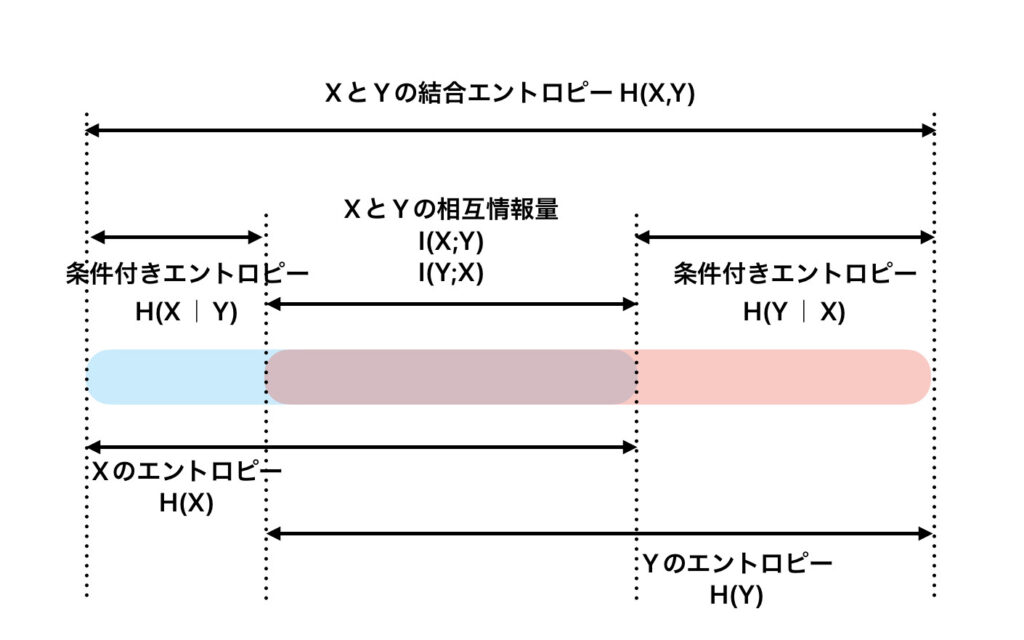

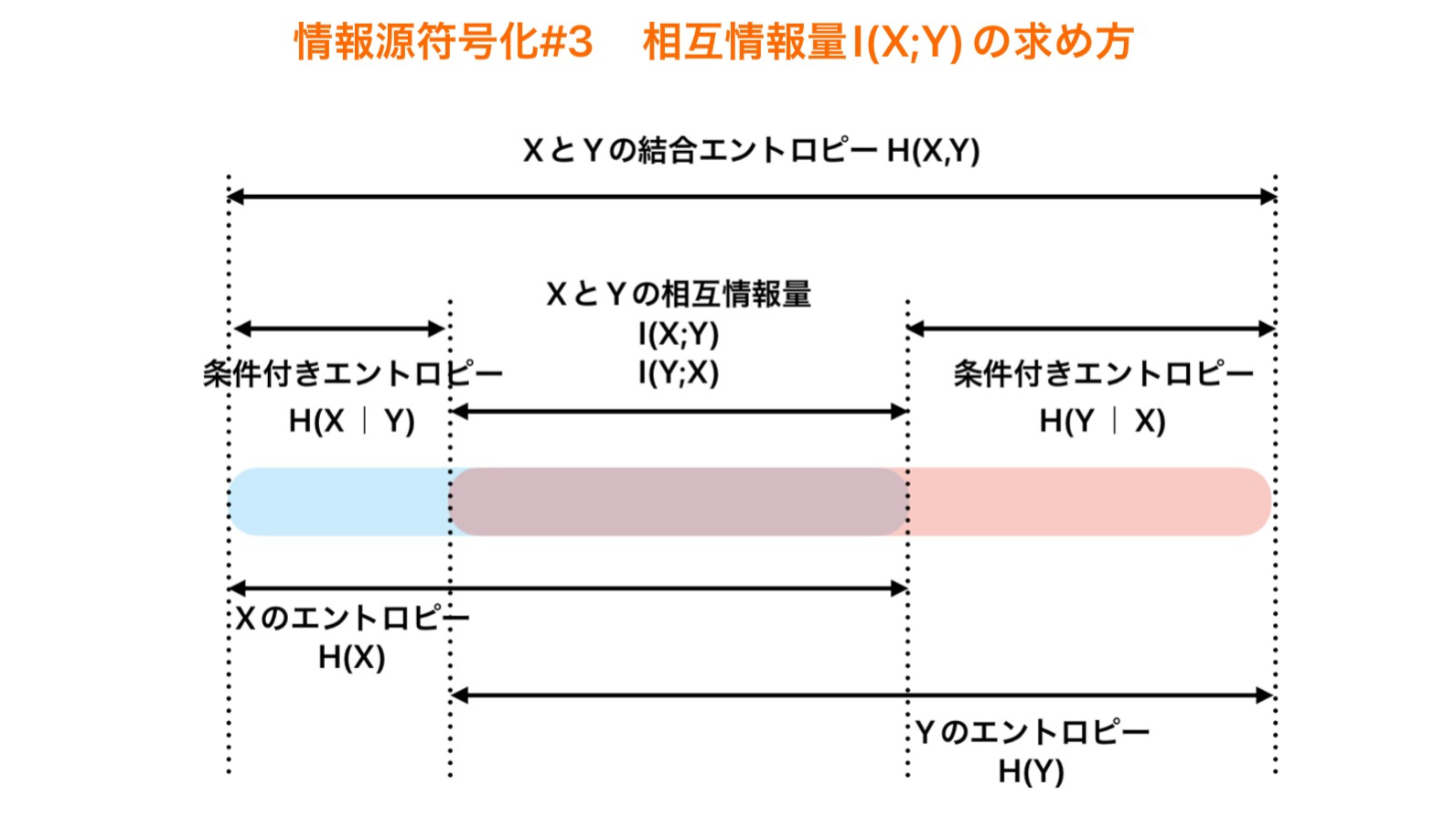

この場合のエントロピーの関係性は以下のようになります。

この図より、次のことがわかります。

I(X;Y)=I(Y;X)

=H(X)+H(Y)-H(X,Y)

=H(X)ーH(X|Y)

=H(Y)ーH(Y|X)

※相互の情報量なので、XとYを入れ替えても問題ありません。

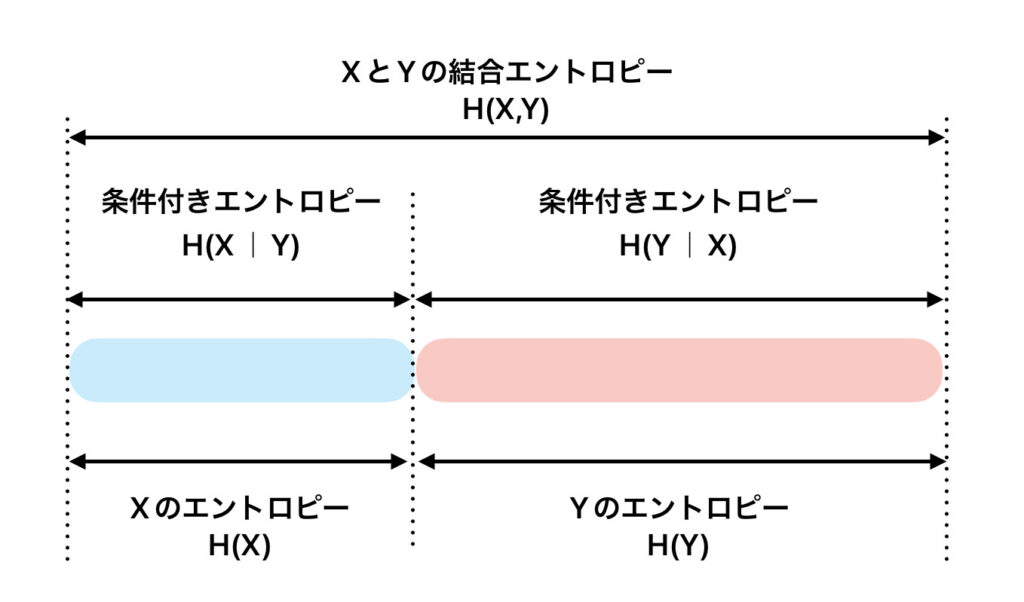

〇XとYが互いに独立している場合

(独立とはXの生起とYの生起に関係性が全くない事)

例えば、

「Xの事象はサイコロの出目」

「Yの事象はコインの裏表」

サイコロの出目で1が出たから、コインで裏がでるなどはありません。

この場合は、Xの事象がYに影響することがありません。

この関係をXとYが互いに独立であると言います。

この場合のエントロピーの関係性は以下のようになります。

例題

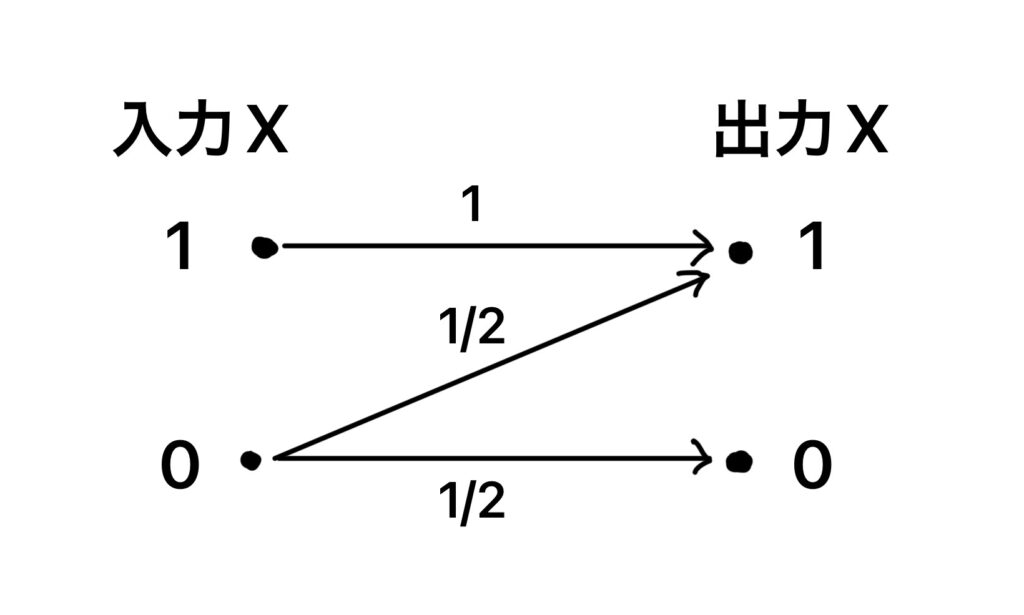

[例題]

図のような2元無記憶通信路を考える。入力X,入力Yとし、いずれもアルファベット{0,1}上の確率変数であるとする。入力X=0となる確率をpとする。2元エントロピー関数h(α)=ーαlog2α ー (1ーα)log2(1ーα)を利用できる場合は、それを用いよ。

(1)エントロピーH(Y)を答えよ。 ←前回の記事#1で解説

(2)条件付きエントロピーH(Y|X)を答えよ。 ←前回の記事#2で解説

(3)相互情報量I(X;Y)を答えよ。 ←今回はココ

(4)通信路容量C0とそれを実現するpの値をそれぞれ答えよ。

(5)2ビットの2元符号M={00,11}を考え、2つの符号語が1/2で生起する。

このとき、復号誤り率Pe(平均誤り率)を答えよ。

(6)(5)の2元符号の伝送速度R(情報速度)を答えよ。

引用:名古屋工業大学 2021年度 大学院工学研究科(博士前期課程)

専門試験問題 (情報工学系プログラム)

解答・解説

(3)相互情報量I(X;Y)を答えよ。

H(Y)=h(p/2) ←前回の記事#1で解説

H(Y|X)=p ←前回の記事#2で解説 より、

I(X;Y)=H(Y)ーH(Y|X)

=h(p/2)-p [ビット/記号]

コメント